Ako fungujú webové prehľadávače? Kompletný technický sprievodca

Zistite, ako fungujú webové prehľadávače – od počiatočných URL adries až po indexovanie. Pochopte technický proces, typy prehľadávačov, pravidlá robots.txt a vp...

Crawlery, známe aj ako spidery alebo boti, systematicky prehľadávajú a indexujú internet, čo umožňuje vyhľadávačom pochopiť a hodnotiť webové stránky pre relevantné dopyty.

Crawlery, známe aj ako spidery alebo boti, sú sofistikované automatizované softvérové programy navrhnuté na systematické prehľadávanie a indexovanie rozsiahlosti internetu. Ich hlavnou úlohou je pomáhať vyhľadávačom pochopiť, kategorizovať a hodnotiť webové stránky na základe ich relevantnosti a obsahu. Tento proces je nevyhnutný pre to, aby vyhľadávače mohli poskytovať používateľom presné výsledky vyhľadávania. Neustálym skenovaním webových stránok crawlery vytvárajú komplexný index, ktorý vyhľadávače ako Google využívajú na poskytovanie presných a relevantných výsledkov.

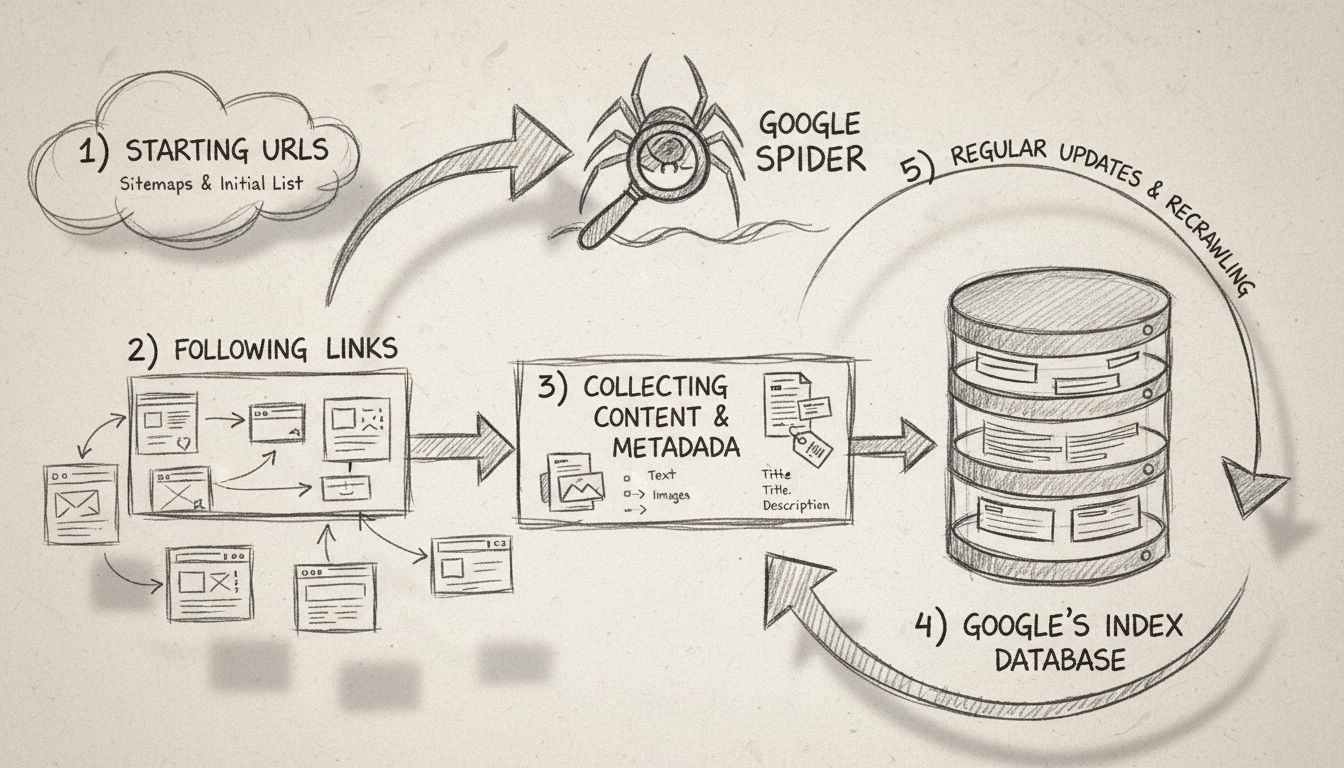

Web crawlery sú v podstate očami a ušami vyhľadávačov, vďaka nim vedia, čo sa na stránke nachádza, rozumejú jej obsahu a určia jej miesto v indexe. Začínajú zoznamom známych URL adries a systematicky prechádzajú každú stránku, analyzujú obsah, identifikujú odkazy a pridávajú ich do svojho frontu na ďalšie prehľadanie. Tento opakujúci sa proces umožňuje crawlerom zmapovať štruktúru celého webu podobne, ako digitálny knihovník kategorizuje knihy.

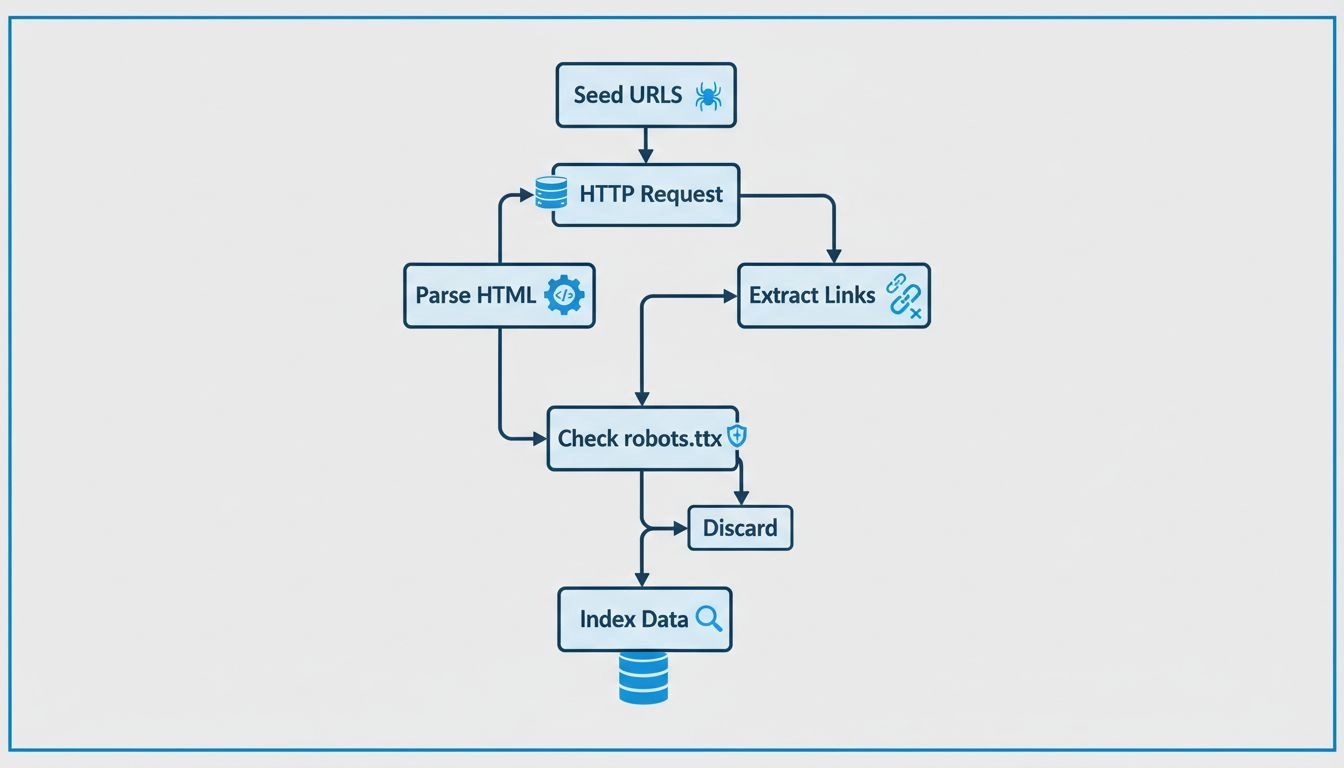

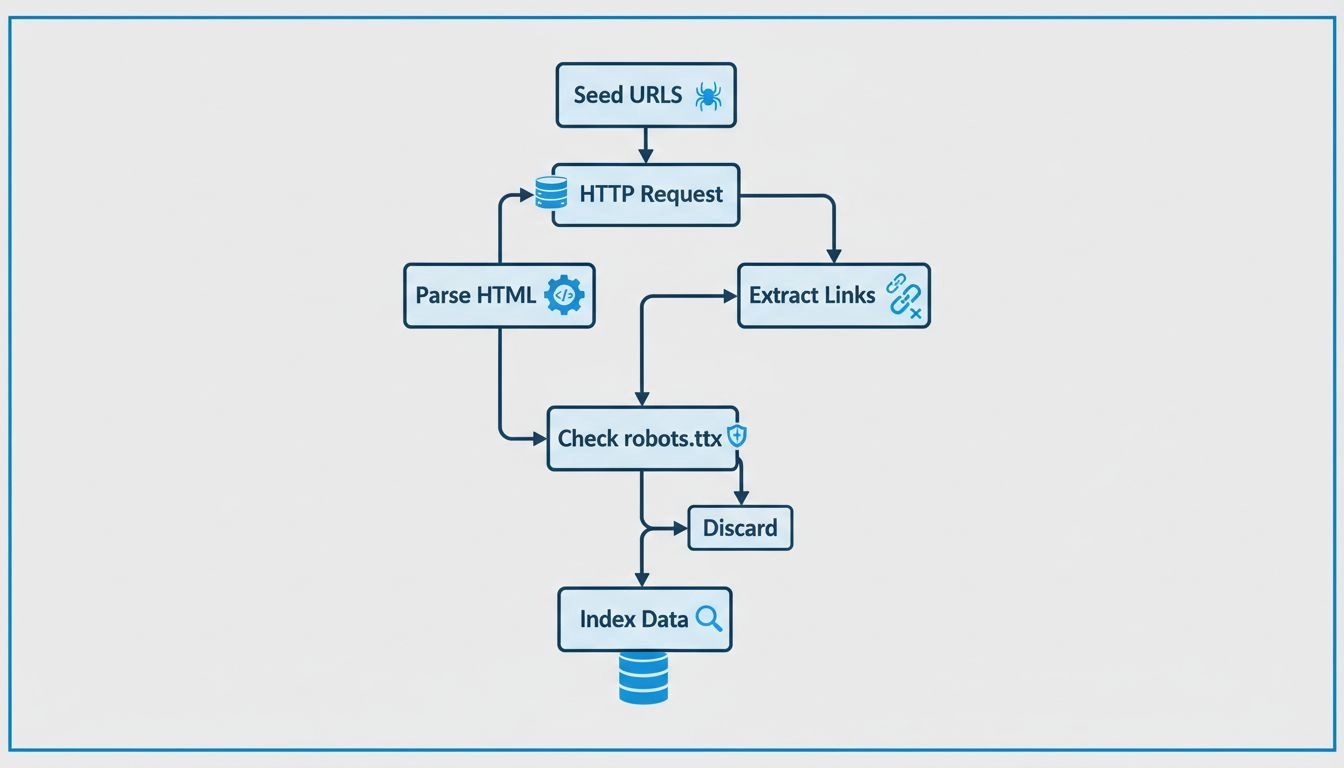

Crawlery fungujú tak, že začínajú s východiskovým zoznamom URL, ktoré navštívia a preskúmajú. Pri prehľadávaní stránok identifikujú odkazy na ďalšie stránky, ktoré pridajú do svojho frontu na ďalšie prehľadávanie. Tento proces im umožňuje zmapovať štruktúru webu, keď sledujú odkazy z jednej stránky na druhú – podobne ako digitálny knihovník usporadúva knihy. Obsah každej stránky vrátane textu, obrázkov a meta tagov je analyzovaný a uložený do obrovského indexu. Tento index slúži ako základ pre vyhľadávače pri získavaní relevantných informácií v odpovedi na dopyty používateľov.

Web crawlery pritom kontrolujú súbor robots.txt každej navštívenej webovej stránky. Tento súbor obsahuje pravidlá, ktoré určujú, ktoré stránky majú byť prehľadané a ktoré ignorované. Po skontrolovaní týchto pravidiel crawlery pokračujú v pohybe po stránke, sledujú hypertextové odkazy podľa stanovených zásad, ako je počet odkazov smerujúcich na stránku alebo autorita stránky. Tieto zásady pomáhajú určiť prioritu prehľadávania tak, aby dôležitejšie alebo relevantnejšie stránky boli indexované včas.

Počas prehľadávania boti ukladajú obsah a metadáta každej stránky. Tieto informácie sú kľúčové pre vyhľadávače pri určovaní relevantnosti stránky voči dopytu používateľa. Zhromaždené údaje sa potom indexujú, čo umožňuje vyhľadávaču rýchlo vyhľadávať a hodnotiť stránky pri zadávaní dopytu.

Pre affiliate marketérov , je pochopenie fungovania crawlerov nevyhnutné na optimalizáciu webu a zlepšenie pozícií vo vyhľadávačoch. Efektívne SEO zahŕňa štruktúrovanie webového obsahu tak, aby bol pre týchto botov ľahko prístupný a zrozumiteľný. Dôležité SEO praktiky zahŕňajú:

V kontexte affiliate marketingu , majú crawlery špecifickú úlohu. Tu je niekoľko dôležitých aspektov:

Affiliate marketéri môžu využiť nástroje ako Google Search Console na získanie prehľadu o tom, ako crawlery interagujú s ich webom. Tieto nástroje poskytujú dáta o crawl chybách, odoslaných sitemapách a ďalších metrikách, čo marketérom umožňuje zlepšovať prehľadateľnosť a indexáciu webu. Monitorovanie crawl aktivity pomáha identifikovať problémy, ktoré môžu brániť indexácii, a umožňuje ich včasnú nápravu.

Indexovaný obsah je nevyhnutný na to, aby bol web viditeľný vo výsledkoch vyhľadávania. Ak stránka nie je indexovaná, vo výsledkoch vyhľadávania sa neobjaví, bez ohľadu na jej relevantnosť voči dopytu. Pre affiliate partnerov , je zabezpečenie indexácie obsahu kľúčové pre získavanie organickej návštevnosti a zvyšovanie konverzií. Správna indexácia zaručí, že obsah môže byť objavený a zaradený na správne miesto.

Technické SEO zahŕňa optimalizáciu infraštruktúry webu pre efektívne prehľadávanie a indexáciu. Patrí sem:

Štruktúrované dáta: Zavedenie štruktúrovaných dát pomáha crawlerom pochopiť kontext obsahu, čím sa zvyšuje šanca webu na zobrazenie v rozšírených výsledkoch vyhľadávania. Štruktúrované dáta poskytujú ďalšie informácie, ktoré môžu zlepšiť viditeľnosť vo vyhľadávači.

Rýchlosť a výkonnosť webu: Rýchlo načítavajúce sa stránky sú uprednostňované crawlermi a prispievajú k pozitívnemu používateľskému zážitku. Zvýšená rýchlosť webu môže viesť k lepším pozíciám a vyššej návštevnosti.

Bezchybné stránky: Vyhľadanie a odstránenie crawl chýb zaručuje, že všetky dôležité stránky sú dostupné a indexovateľné. Pravidelné audity pomáhajú udržiavať zdravie webu a zlepšovať SEO výkon.

Crawlery vyhľadávačov možno identifikovať viacerými spôsobmi – napríklad kontrolou user-agent reťazca crawlera, skúmaním IP adresy crawlera alebo sledovaním vzorcov v hlavičkách požiadaviek.

Web crawlery fungujú tak, že posielajú požiadavky na webové stránky a sledujú odkazy na týchto stránkach na ďalšie weby. Evidujú si navštívené stránky a nájdené odkazy, vďaka čomu môžu indexovať web a umožniť jeho vyhľadávanie.

Web crawlery sa nazývajú spidery, pretože prechádzajú webom, sledujú odkazy z jednej stránky na druhú.

Zistite, ako pochopenie crawlerov a optimalizácia pre nich môže zvýšiť viditeľnosť vášho webu a zlepšiť pozície vo vyhľadávačoch.

Zistite, ako fungujú webové prehľadávače – od počiatočných URL adries až po indexovanie. Pochopte technický proces, typy prehľadávačov, pravidlá robots.txt a vp...

Vyhľadávač je softvér vytvorený na uľahčenie vyhľadávania na internete pre používateľov. Prehľadáva milióny stránok a poskytuje najrelevantnejšie výsledky....

Zistite, čo je Google Spider (Googlebot), ako prehľadáva a indexuje webové stránky a prečo je dôležitý pre SEO. Objavte, ako optimalizovať svoj web pre lepšie p...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.